このセクションの他の記事

アンダーサンプリング

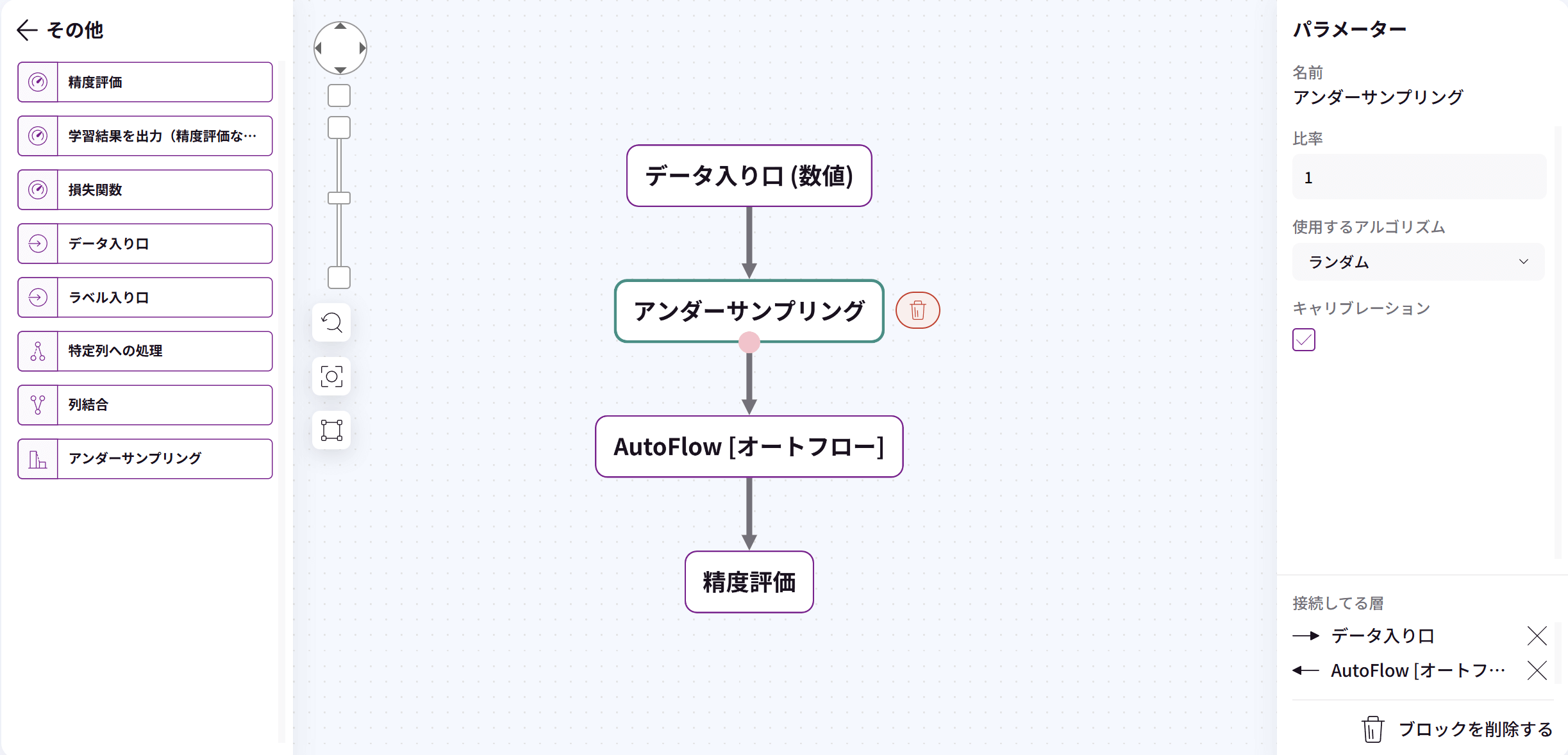

アンダーサンプリングブロックは、データの偏り(不均衡データセット)のバランスを取るための手法です。

ブロックタイプ「その他」にあります。

元の不均衡データセット:

クラスA (多数派): 🔵🔵🔵🔵🔵🔵🔵🔵🔵🔵🔵🔵🔵🔵🔵 (1,000件)

クラスB (少数派): 🔴🔴🔴 (100件)

アンダーサンプリング後:

クラスA (多数派): 🔵🔵🔵 (100件)

クラスB (少数派): 🔴🔴🔴 (100件)

■パラメータ

比率:分ける比率を変更できます。

1.未処理:クラスA:478件 クラスB:18件 クラスC:144件

2.比率1の場合:クラスA:18件 クラスB:18件 クラスC:18件

3.比率2の場合:クラスA:36件 クラスB:18件 クラスC:36件

4.比率100の場合:クラスA:180件 クラスB:18件 クラスC:144件

使用するアルゴリズム:ランダム法 / 重心法

■不均衡のデータセットで学習する際の問題点

1.多数派クラスへの偏り:AI(モデル)は全体の精度を最大化しようとするため、単純に多数派クラスを予測すれば高い精度が得られてしまいます。

2.少数派クラスの軽視:例えば”詐欺の検出”で99.9%が”正常な取引”の場合、「すべて正常」と予測するだけで99.9%の精度となりますが、”0.1%の詐欺”を見逃してしまいます。疾病に置き換える場合、0.1%の病人を見逃すということです。

3.評価指標の誤解釈:全体の正解率(accuracy)は高くても、少数派クラスの検出能力(再現率・適合率)が極めて低くなる可能性があります。

4.決定境界の歪み:多数派クラスのデータポイントが支配的になり、適切な決定境界が学習できません。

多数派クラスのサンプル数を減らすことで、少数派クラスとのバランスを改善します。

■アンダーサンプリングの有用性

1.クラスバランスの改善:多数派クラスのサンプル数を減らすことで、少数派クラスとのバランスを取り、AIが少数派クラスの特徴をより学習しやすくなります。

2.計算効率の向上:データ量が減るため、学習時間が短縮され、計算にかかる時間と能力(リソース)を節約できます。

3.少数派クラスの検出率向上:少数派クラスへの感度が高まり、再現率(リコール)が向上します。これは詐欺検出や疾病診断など、見逃しのコストが高い領域で特に重要です。

4.決定境界の改善:クラス間のバランスが取れることで、より適切な決定境界を学習できます。

5.複雑なAIの低減:一部のケースでは、より単純なAIで良好な性能を達成できるようになります。

ただし、アンダーサンプリングには多数派クラスの重要な情報を失うリスクもあります。うまくいかない場合は、データの性質や問題に応じて他の手法と併用することも検討してください。(専門的な知識が必要です)

キャリブレーション

AIを作る上で、「可能な限り予測を当ててほしい」は、誰しもが思う事です。

例えば、天気予報士が「明日は80%の確率で雨が降る」と言ったとします。理想的には、実際に「80%の確率で雨が降る」という予報が出た日を100日分集めると、そのうち約80日は実際に雨が降るはずです。しかし、もし予報士が自信過剰で、「80%の確率で雨」と言った日に実際には60日しか雨が降らなかったとしたら、この予報士の予測は「キャリブレーションされていない」状態といえます。

この問題を解消するのが「キャリブレーション」で、機械学習モデル(AI)の「自信度」と「実際の正確さ」を一致させる作業です。

キャリブレーション前:

予測確率: 0.9

実際の正解率: 0.7 → 過信

キャリブレーション後:

予測確率: 0.7

実際の正解率: 0.7 → 適切に調整※

※自分(AI)が知識の限界を正確に把握している。キャリブレーションが良いと言える。

キャリブレーションが重要なのは以下のような場面です。

1.医療診断:「このデータから90%の確率で肺炎です」と言われたら、本当に90%の確率であってほしい

2.リスク評価:融資審査や保険料算定など、確率に基づく重要な意思決定の場面